(原标题:从“快响应”到“深思考”,李未可AI眼镜开启千亿智能穿戴新赛道)

引言:

在行为经济学著作《思考的快与慢》中,丹尼尔·卡尼曼将人类思维划分为两个系统:系统1代表快速、直觉、自动化的反应,而系统2则负责缓慢、理性、深度的思考。这一理论不仅解释了人类的决策机制,也为人工智能的交互设计提供了灵感。

李未可创始人茹忆强调“交互的本质是顺应人的认知习惯,交互形态决定了产品形态,而眼镜与人类的交互器官距离最近,因此它是最理想的交互载体”。作为国内首个通过大模型备案的AI眼镜开创品牌,李未可始终致力于将多模态感知、情感化陪伴与高效响应能力,融入人类最自然的“看、听、说”之中,让AI成为随身、随思、随需的“第二大脑”。

出差抵达国外机场,指示牌和广播播报实时翻译入耳;商务会谈中,对话内容同步转译并生成要点;考察工厂时,设备说明与安全标识一拍即解;酒店签单,外币金额即时换算并核对。

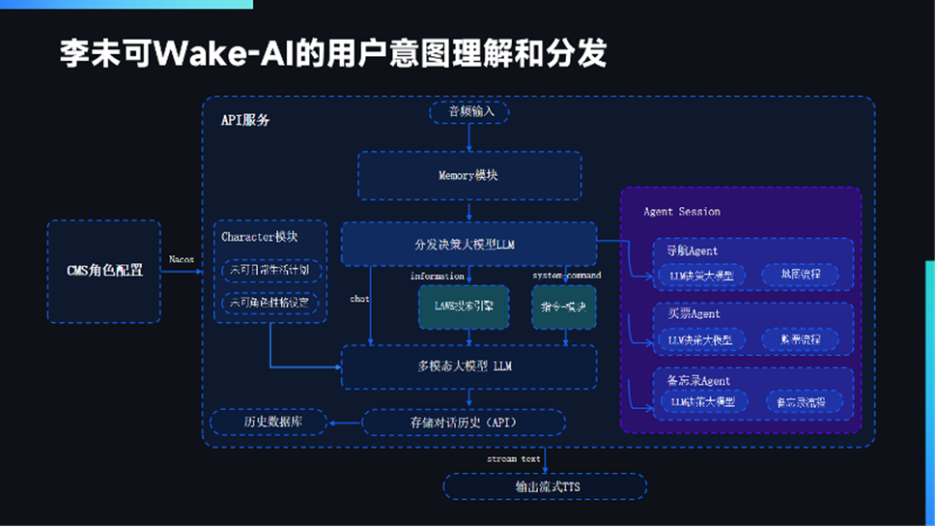

实现这一切的背后,是李未可全面升级的 “超能李未可”系统。基于自研WAKE-AI 大模型基础,采用多智能体协同的“群体智能”模式,协同20+主流大模型与70+智能体,根据任务的复杂程度实现动态调度与决策,完成从“即时应答”到“深度协同”的无缝衔接。通过端到端的任务理解与执行闭环,使系统能够自主完成从指令解析、规划拆解到结果交付的全过程。

高效“快响应”: 全天候即时全能助手

这是默认的 “人机交互模式”,基于自研WAKE-AI 大模型,它的价值在于无处不在的高效便捷,通过眼镜的“短平快”交互,解放双手与注意力。无论是行程查询、语音速记、即时翻译都能随问随答,覆盖生活、工作、学习、出行等全场景应用:晨跑时语音获取天气与新闻简报,通勤中语音安排全天日程,会议间隙语音记录要点并生成摘要。

实现以上技术关键在于构建了一条超高效率的从感知、决策到执行的链路:结合科大讯飞算法降噪,依托ENC技术通过多麦克风阵列和Beamforming指向增强技术,即使在环境噪声下也能实现毫秒级语音唤醒与识别能力,在意图理解上,由WAKE-AI模型对指令进行意图分类,包括识别天气查询、新闻资讯、LBS服务、多模态语音识别等各种意图理解,调用对应服务模块给出结果,全程在百毫秒内完成。

深度“慢思考”:超能协同智慧专家

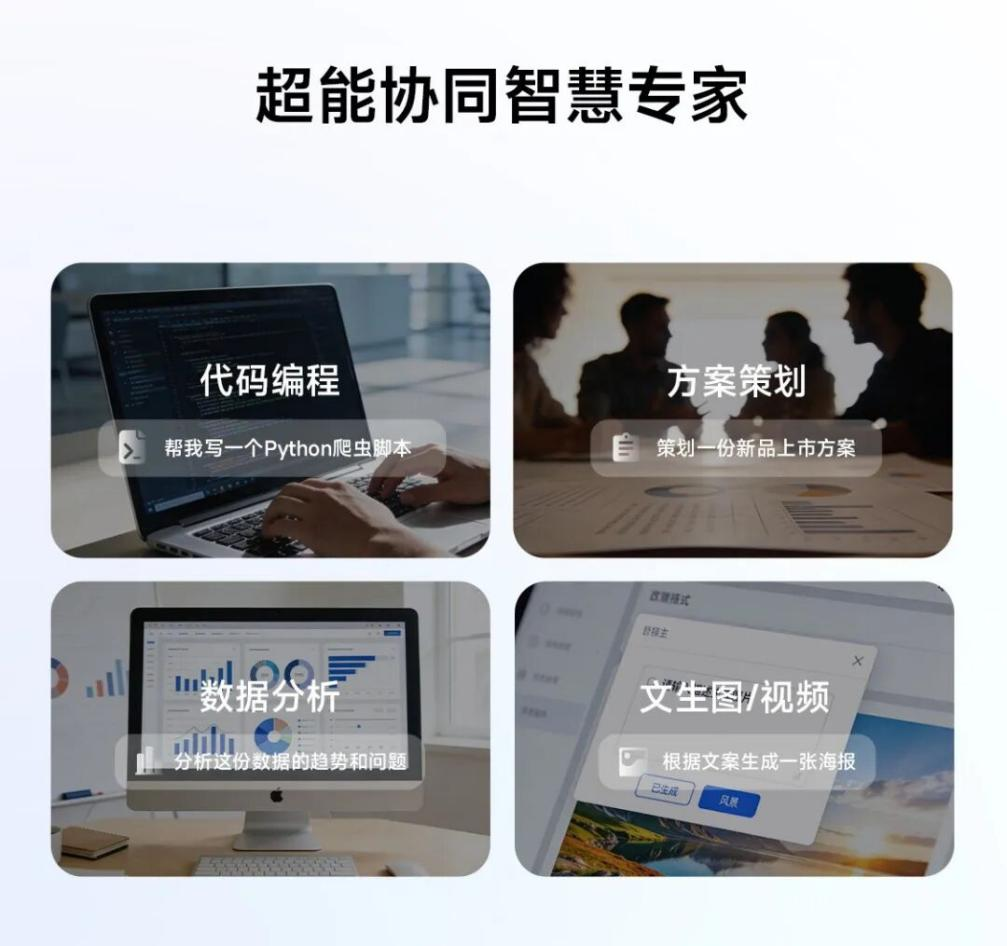

当任务超越简单问答,需要深度思考、创意生成或复杂执行时,系统自动切换至 “慢思考”超能李未可模式,启动 “超能协同智慧专家”。基于新一代多智能体架构为核心,深度融合了DeepSeek、通义千问、文心一言等20+主流模型与70+专业智能体。系统不仅调用工具,更进行自主规划、分步推理、动态执行与持续优化——这正是李未可聚焦 MultiAgents(多智能体) 能力的核心体现:

设计师可以说:“根据品牌调性,结合当地节日风俗,生成三套视觉设计方案。”李未可AI APP上随即呈现不同风格的概念图,并可语音调整细节;

程序员提出:“优化这段代码的时间复杂度。”不仅给出优化方案,还可逐行解释改进逻辑;

市场人员要求:“分析东南亚XX品类趋势,输出针对性策略。”系统调用数据爬取、竞品分析、文化适配、报告生成等多智能体,输出结构化方案;

支撑以上场景体验的,正是李未可构建的独特 “智能体协同生态”。内核是其构建的 PPDAF(感知-Perception, 规划-Planning, 决策-Decision, 执行-Action, 反馈-Feedback)循环框架,在这个框架下实现端到端系统的完整构建。“当你说‘帮我策划一个新品发布会’时,启动的不是一个程序,而是一个虚拟团队,”茹忆这样解释系统的工作机制,“创意策划、预算规划、场地设计、流程安排……不同智能体协同工作,最后给你一个完整方案。”

基于这一强大的智能体架构,李未可构建了“全场景AI翻译矩阵”,支持全球128种语言及方言实时互译,涵盖同声传译、听译转写、拍照翻译及离线翻译等多场景需求。尤其针对跨语言商务场景,可调用专业术语库、语境还原与文化映射等专项能力,确保实现准确、专业且有商业温度的转译。凭借对“一带一路”多元场景的深度适配,李未可AI智能眼镜正成为中国企业出海过程中的高效“跨语言桥梁”。

在推动自身技术演进的同时,李未可亦致力于构建开放生态。2025年5月,李未可正式开放 WAKE-AI 2.0 架构、自主接入智能体广场,同时联合阿里云、微软云等企业成立“智能眼镜生态联盟”,推动AI眼镜从硬件创新走向场景生态构建。

李未可的愿景,是让AI眼镜成为用户的 “第二大脑”,它不仅是终端辅助设备,更是记忆的延伸、感知的增强与场景的智能枢纽。正如品牌创始人茹忆所言:“AI眼镜不应是科技的冰冷载体,而应成为连接人与数字世界的温暖入口“。这一切,始于让技术回归本质:增强人类感知、理解与创造世界的能力,让人更自由地成为人自己。

看见即交互,协同即智能。

李未可,让效率更自由,让未来触手可及。

本文来源:财经报道网