(原标题:英伟达下一个“大杀器”)

今天这个料有点猛,GB200、GB300、VR200之后,英伟达还在规划什么?如下图(from 肉总)

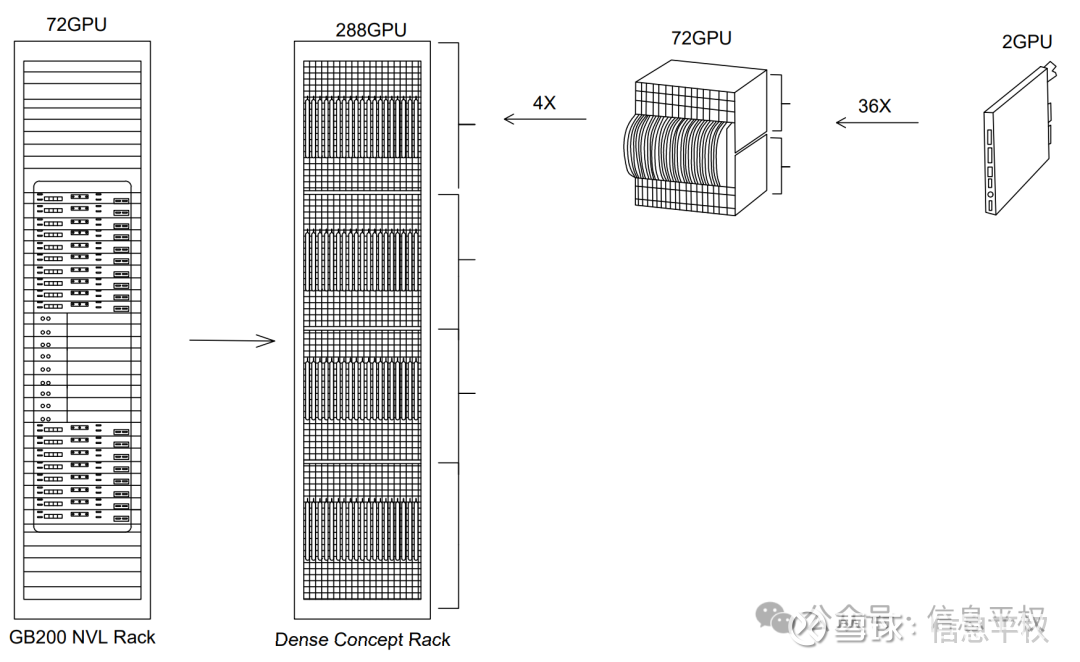

其实相当于,将4个NVL72继续压缩成一个288卡单机柜。这里有太多有趣的点值得咀嚼:

1. 我第一反应是,这玩意靠谱吗?问了特别敬佩的一位美国大哥,他之前就参与过IBM大型机研发,当时GB200出来他提出了很多尖锐的问题。他看完这个288卡“怪物”竟然觉得,make sense...因为模型工作负载的重心变了...

2. 什么样的负载?显然是推理。训练时代,后向传播需要超大规模的模型并行,从而强调大集群、机柜间互联(inter-rack);而推理,尤其是小模型、多步推理,强调的不是大集群,而是局部强互联,或者“超节点”(intra-rack)。之前文章曾经说过,HBM解决了访存带宽最高性价比,而成本、能耗更低的铜缆实现的超节点,解决了单机柜内卡间互联最高性价比,从而大幅降低推理成本(从pre-fill和decode两个推理的进程来看,推理成本的本质是带宽成本)。从最近模型进展来看(尤其是o1),NV这种超节点大机柜的确定义的非常精准。

3. 其次,铜缆的生命周期可能比想象中长。这不是光和铜谁替代谁的问题,而是AI下游工作负载迁移的问题...任何产业都会从研发走向“生产部署”,而推理占据90%以上负载可能只是时间问题。而推理更强调局部互联,说到底,铜缆是目前低成本、低功耗、高稳定性地实现局部互联的最佳方式。因此不用讨论Rubin还用不用铜缆,铜缆可能会持续很多代。黄仁勋2天前和ARM CEO有个播客建议大家去听,其中提到一句:“尽可能长时间的使用铜/电传输,从而降低成本和复杂性”

4. 之前8机柜576卡互联的问题得到了解答。之前按照GB200机柜之间的距离,用无源铜缆连接是不可能的。而按照这个示意图,相当于把NVL72机柜进一步压缩,机柜之间的距离,拉到了甚至 1 米以内,也就是无源铜缆可以覆盖的距离,从而实现了L1层网络全铜连接。而铜缆可以实现的NVLink domain,从72扩展到了288,关键问题来了,这需要一个超强的交换机,没错,是个288 High radix switch...

5. 散热如何解决...这可能是我最大的疑问。毕竟现在NVL72的散热就搞了好久..而图中这个设计,的确是100%水冷,但288卡塞到一个rack(暂时不知道这是多少U或者多高的机柜),还是难以想象。其次,这个单机柜功耗是1MW...什么概念,目前GB200是120kw,已经需要新建IDC,那么1MW…这里画一个大大的问号。

6.系统稳定性如何?如果这次GB200遇到的问题最终解决(散热、铜缆、cowos-L),有可能给Vera Rubin以及这个288卡“怪物”铺平了路。从Blackwell这次的delay可以看到,芯片每年一迭代的难度是极大的,但在软件和系统层面每年做优化却简单很多,通过board level的集成实现性能飞跃,可能的确是更稳妥的一条路。

7. 最重要的问题,这玩意,可以再把推理成本降低多少?不知道定价、精度等因子,如果只看单机柜的性能perf,可以非常粗略的计算,288卡、单卡假设4颗die、NVlink假设至少翻倍、HBM也至少翻倍,整个机柜的性能应该是GB200的至少30倍...而从perf/W的角度,大概提升了4倍的能耗效率。因此,回到我们那句老话,英伟达是“因”而不是“果”,是NV在推动行业的进步,将o1这种reasoning model的成本再降低一个数量级,maybe可以让应用的诞生更快一点...

8. 最后,总结下未来3年的英伟达产品线:2025H1行业大规模部署GB200,2025H2部署GB300/GB300A,2026部署Rubin系列的VR200,2026年底或者2027部署这个288卡的“Rubin-Next”。未来3年推理成本下降曲线清晰可见。

最后要声明,图中所示,isearly concept to illustrate direction, not final design”,即NV的早期设计概念。不过目前看下来,相对靠谱,符合下一步推理负载的演进趋势,也依然延续着NV“系统性能数量级提升”的老路。GB200高强度拉练了一遍供应链,快速扫清了茫茫多工程障碍,之后“系统压缩”这条路可能也相对顺畅一些。

(完)